Mesurer le bien-être et la soutenabilité : un numéro de la Revue de l’OFCE

par Eloi Laurent

Ce numéro de la Revue de l’OFCE (n° 145, février 2016) présente certains des meilleurs travaux qui se développent à grande vitesse autour des indicateurs de bien-être et de soutenabilité.

Pourquoi vouloir mesurer le bien-être ? Parce que l’idée que la croissance économique représente le développement humain au sens où elle constituerait un bon condensé de toutes ses dimensions est tout simplement fausse. La croissance du PIB n’est pas une condition préalable du développement humain, c’est au contraire, désormais, souvent son entrave (comme l’illustre le coût sanitaire exorbitant de la pollution atmosphérique en Inde et en Chine, deux pays qui concentrent un tiers de la population humaine). Dès lors, l’augmenter ne suffit pas à se développer humainement, il y faut des politiques spécifiques qui se donnent pour objet direct l’éducation, la santé, les conditions environnementales ou encore la qualité démocratique. Sans la considération de cette pluralité du bien-être, une dimension, généralement la dimension économique, s’impose aux autres et les écrase, mutilant le développement humain des individus et des groupes (l’exemple de la santé aux Etats-Unis est particulièrement frappant à cet égard).

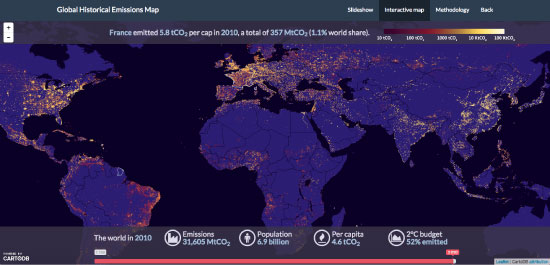

Pourquoi vouloir mesurer la soutenabilité ? Parce qu’un taux de croissance mondiale de 5 % aujourd’hui nous importe peu si le climat, les écosystèmes, l’eau et l’air qui sous-tendent notre bien-être se sont irrévocablement dégradés en deux ou trois décennies du fait des moyens déployés pour atteindre cette croissance. Ou pour le dire avec les mots du ministre de l’Environnement chinois, Zhou Shengxian, en 2011 : « si notre terre est ravagée et que notre santé est anéantie, quel bienfait nous procure notre développement ? ». Il faut donc actualiser notre bien-être pour que celui-ci ne soit pas qu’un mirage. Nos systèmes économiques et politiques n’existent que parce qu’ils sont sous-tendus par les ressources d’un ensemble qui les contient, la biosphère, dont la vitalité est la condition de leur perpétuation. Pour le dire brutalement, si les crises écologiques ne sont pas mesurées et maîtrisées, elles finiront par balayer le bien-être humain.

Les indicateurs de bien-être et de soutenabilité doivent donc entrer dans un nouvel âge, performatif : après avoir mesuré pour comprendre, il nous faut à présent mesurer pour changer. Évaluer pour évoluer. Car le changement qu’appellent ces nouvelles visions du monde économique est considérable. Ce temps de l’action implique toujours des choix et des arbitrages qui n’ont rien de simple. C’est précisément le double objet de ce numéro de la Revue de l’OFCE : montrer que les indicateurs de bien-être et de soutenabilité sont parvenus à maturité et qu’ils peuvent désormais non seulement changer notre vision du monde économique mais notre monde économique lui-même ; donner à voir les types de choix qui se présentent aux décideurs privés et publics pour mener à bien ce changement. Les deux parties qui composent ce numéro mettent à cet égard clairement en lumière la question de l’échelle pertinente de la mesure du bien-être et de la soutenabilité.

La première partie de ce numéro est consacrée au sujet relativement nouveau de la mesure du bien-être territorial en France. Mesurer le bien-être là où il est vécu suppose en effet de descendre vers l’échelle locale la plus fine : la nécessité de mesurer et d’améliorer le bien-être humain au plus près des réalités vécues par les personnes, de même que l’ampleur des inégalités spatiales dans la France contemporaine impose la perspective territoriale. Il existe au moins deux raisons fortes qui font des territoires (régions, métropoles, départements, villes), plus que les États-nations, les vecteurs par excellence de la transition du bien-être et de la soutenabilité. La première tient à leur montée en puissance sous le double effet de la mondialisation et de l’urbanisation. La seconde tient à leur capacité d’innovation sociale. On parle à ce sujet, à la suite de la regrettée Elinor Ostrom, de « transition polycentrique » pour signifier que chaque échelon de gouvernement peut s’emparer de la transition du bien-être et de la soutenabilité sans attendre une impulsion venue d’en haut.

Monica Brezzi, Luiz de Mello et Éloi Laurent (« Au-delà du PIB, en-deçà du PIB : Mesurer le bien-être territorial dans l’OCDE ») donnent à voir les premiers résultats de travaux théoriques et empiriques conduits actuellement dans le cadre de l’OCDE (accessibles de manière interactive sur le site http://www.oecdregionalwellbeing.org/ ) pour mesurer certaines dimensions du bien-être au niveau régional et appliquer ces nouveaux indicateurs au cas français afin d’en tirer d’utiles enseignements pour les politiques publiques.

Robert Reynard (« La qualité de vie dans les territoires français ») propose un panorama des résultats obtenus récemment par l’Insee à l’aide d’indicateurs territoriaux de qualité de vie qui permettent de constituer une nouvelle typologie des espaces français mettant en évidence huit grands types de territoires, qui se distinguent à la fois par les conditions de vie de leurs habitants (emploi, revenus, santé, éducation, etc.) et par les aménités que les territoires offrent à leur population (cadre de vie, accès aux services, transports, etc.). La nouvelle représentation de la France qui en résulte constitue une aide précieuse à la décision pour ceux qui ont en charge les politiques visant l’égalité des territoires.

Kim Antunez, Louise Haran et Vivien Roussez (« Diagnostics de qualité de vie : Prendre en compte les préférences des populations ») reviennent sur l’approche développée dans le cadre de l’Observatoire des territoires et mettent en lumière les indicateurs, proposés à des échelles géographiques adaptées, qui permettent de rendre compte du caractère multidimensionnel de la qualité de vie en France. Ici aussi, des typologies de territoires explorent le lien entre les aménités variées des cadres de vie et les aspirations diverses des populations qui y résident, pour souligner les déséquilibres existants et les leviers d’action publique mobilisables pour les réduire.

Enfin, Florence Jany-Catrice (« La mesure du bien-être territorial : travailler sur ou avec les territoires ? ») insiste sur une dimension fondamentale de ce débat sur la mesure du bien-être territorial français : la participation des citoyens à la définition de leur propre bien-être. Elle montre notamment que la portée des indicateurs retenus dépend du fait que celles et ceux qui les élaborent travaillent sur les territoires ou avec eux, c’est dans ce dernier cas seulement que le territoire et ses habitants deviennent de véritables acteurs dans l’élaboration d’une vision partagée.

Mais mesurer la soutenabilité suppose, à l’inverse de ces approches localisées, de remonter l’échelle géographique vers le national et même le niveau global. C’est l’objet des articles de la seconde partie de ce numéro qui porte sur un sujet dont l’importance a été encore soulignée par la récente loi sur la transition énergétique : l’économie circulaire. Il y a ici une différence cruciale à opérer entre une économie apparemment circulaire, qui concernerait un produit ou une entreprise et la véritable circularité économique, qui ne peut s’apprécier qu’en élargissant la boucle pour parvenir à une vision systémique.

C’est ce qu’entendent démontrer Christian Arnsperger et Dominique Bourg (« Vers une économie authentiquement circulaire : réflexions sur les fondements d’un indicateur de circularité ») en s’interrogeant sur les principaux aspects, enjeux et questionnements que les concepteurs d’un indicateur d’économie authentiquement circulaire, s’il devait un jour être bâti au plan formel et technique, devraient prendre en compte. Ils concluent notamment que sans une vision systémique orientée vers la réduction, le rationnement et la stationnarité propres à l’approche perma-culturelle, l’idée d’économie circulaire restera constamment vulnérable à une récupération peut-être bien intentionnée, mais finalement de mauvais aloi.

Vincent Aurez et Laurent Georgeault (« Les indicateurs de l’économie circulaire en Chine ») s’efforcent justement d’évaluer la pertinence et la portée réelle des outils d’évaluation développés ces dernières années par la Chine pour donner corps à une politique intégrée d’économie circulaire ayant pour objectif d’assurer la transition vers un modèle sobre en ressources et bas carbone. Ces instruments, à bien des égards uniques mais encore insuffisants, se distinguent par leur caractère systémique et multidimensionnel et constituent dès lors un apport original au champ des indicateurs de soutenabilité.

Finalement, Stephan Kampelmann (« Mesurer l’économie circulaire à l’échelle territoriale : une analyse systémique de la gestion des matières organiques à Bruxelles »), mobilisant la théorie des systèmes socio-écologiques, se livre à un exercice particulièrement novateur consistant à comparer, selon une batterie d’indicateurs d’impact économiques, sociaux et environnementaux, deux trajectoires possibles pour la gestion municipale des flux de matières organiques à Bruxelles : un traitement centralisé par biométhanisation et un traitement par compostage décentralisé.

Ainsi donc, si le bien-être se mesure le mieux à l’échelle locale, la soutenabilité, y compris celle des territoires, s’évalue correctement en tenant compte de l’impact ressenti au-delà des frontières locales ou nationales. Des arbitrages apparaissent alors entre ces dimensions, dont l’exploration et la possible transformation en synergies au niveau territorial et national constituent les chantiers les plus prometteurs ouverts par la transition du bien-être et de la soutenabilité.