États-Unis : les ménages continuent de puiser dans leur sur-épargne

par Christophe Blot

Selon le Bureau of Economic Analysis, la croissance américaine au premier trimestre 2023 a atteint 0,3 %, niveau légèrement supérieur à ce que nous avions anticipé[1]. Cette première estimation traduit la résilience de l’économie malgré la forte hausse de l’inflation qui ampute le pouvoir d’achat des ménages et le resserrement monétaire qui se traduit par un renchérissement des conditions de crédit et une baisse de la valeur des actifs boursiers. Comment expliquer cette situation conjoncturelle ? L’économie américaine peut-elle résister au resserrement monétaire ? Tout dépendra sans doute de l’évolution du taux d’épargne des ménages américains.

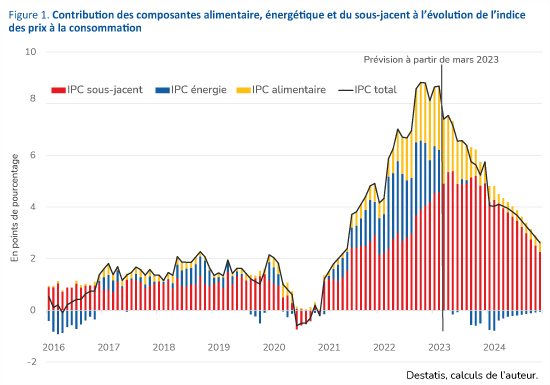

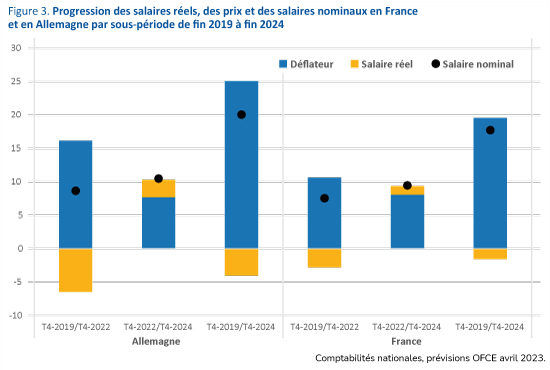

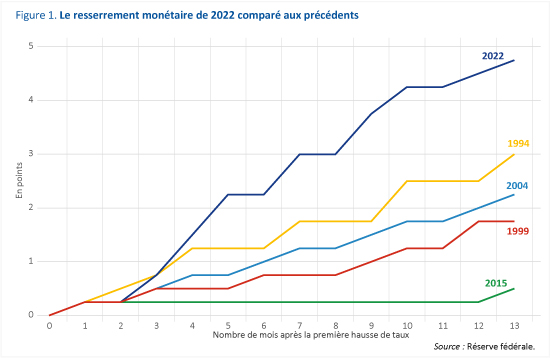

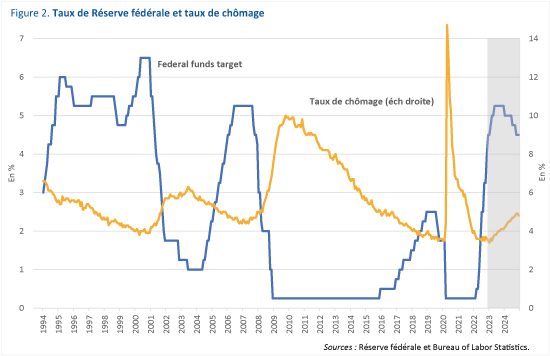

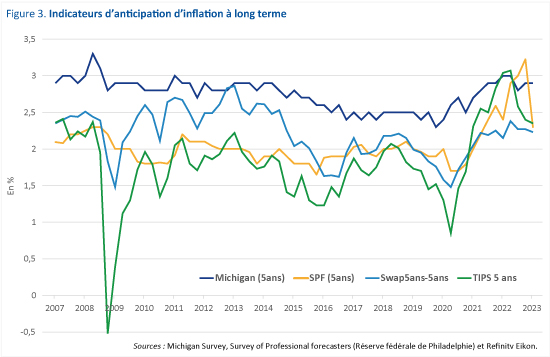

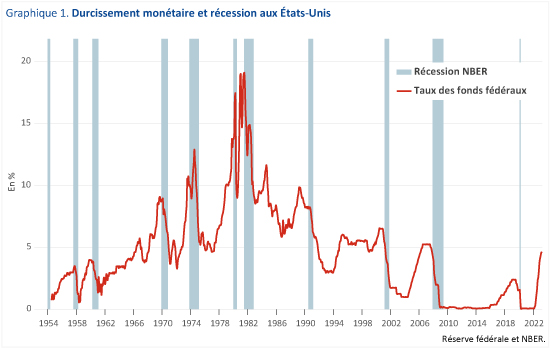

La publication des comptes pour le premier trimestre 2023 indique que la croissance a été principalement tirée par la demande intérieure hors stocks qui contribue à hauteur de 0,8 point tandis que les stocks ont joué très négativement (-0,7 point de contribution) et que le commerce extérieur a eu un effet quasi-neutre. Le moteur de la croissance reste la consommation des ménages qui a progressé de 0,9 % en rythme trimestriel[2]. Une telle situation pourrait surprendre dans la mesure où l’inflation rogne le pouvoir d’achat des ménages[3]. Même si elle est en repli depuis plusieurs mois, l’inflation mesurée par l’évolution du déflateur de consommation progressait encore de 4,9 % en glissement annuel au premier trimestre. Pour autant le pouvoir d’achat des ménages affiche une progression de 1,9 % au premier trimestre en raison de la bonne tenue de l’emploi et des salaires mais également d’une baisse des impôts[4]. Outre l’effet négatif de l’inflation, l’économie américaine est également freinée par le resserrement monétaire amorcé il y a un an par la Réserve fédérale[5]. L’effet de ce resserrement devrait s’amplifier. Depuis le milieu des années 1950, les récessions outre-Atlantique ont été souvent précédées d’un changement d’orientation de la politique monétaire (graphique 1). La corrélation n’indique pas forcément que la politique monétaire est seule responsable de ces récessions mais la théorie économique suggère clairement que la politique monétaire a joué un rôle via un effet négatif sur la demande intérieure[6]. De fait aujourd’hui, l’effet de la hausse des taux pourrait déjà avoir impacté les dépenses en investissement-logement qui continuent de baisser au premier trimestre.

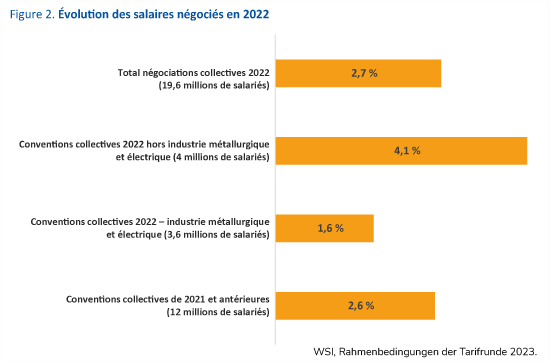

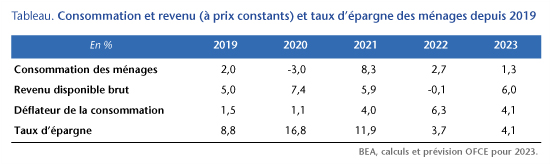

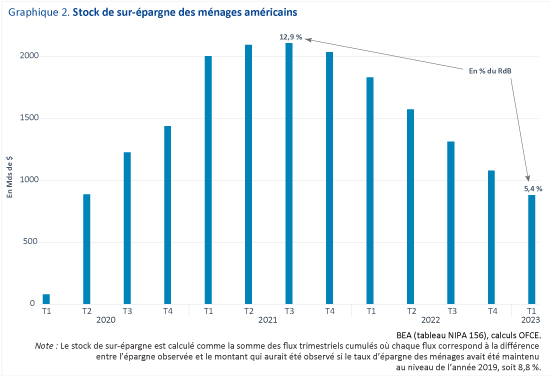

La résilience de l’économie américaine dépendra cependant en grande partie de l’évolution de la consommation des ménages dont la dynamique a largement contribué à la reprise post-Covid. Depuis 2019, le revenu disponible des ménages (RdB) a progressé de 18,5 % en valeur reflétant à la fois le dynamisme des salaires au cours de la période mais également la politique généreuse de transferts menée par les administrations Trump puis Biden en 2020-2021[7]. Alors que les transferts représentaient en moyenne 19 % du RdB des ménages entre 2011 et 2019, cette part est montée à 24 et 25 % respectivement en 2020 et 2021. Il en a résulté une augmentation du taux d’épargne des ménages qui s’est élevé à 16,8 % du RdB en 2020 avec un pic à 26,4 % au deuxième trimestre dans un contexte où la consommation fut également contrainte (tableau). Sur l’année 2022, les mesures exceptionnelles prises pendant la crise sanitaire sont arrivées à terme et les ménages ont moins épargné, ce qui a permis d’amortir la baisse de pouvoir d’achat résultant de la poussée inflationniste. Le taux d’épargne est redescendu à 3,7 % alors que le RdB réel diminuait de 0,1%. Au premier trimestre 2023 le taux d’épargne s’établit à 4,8 %, en hausse par rapport au trimestre précédent. Sur l’ensemble de l’année, nous anticipons un taux d’épargne moyen de 4,1 %, ce qui implique une réduction du stock de sur-épargne qui avait atteint un pic à plus de 2 100 milliards de dollars, soit 12,9 % du RdB (graphique 2)[8]. Nous prévoyons certes un ralentissement mais pas de récession avec une croissance annuelle du PIB de 1,4 %. En effet, même si le gain de revenu disponible a été en partie rogné par l’inflation[9], l’épargne liquide – dépôts, comptes d’épargne et titres des fonds commun de placements monétaires – des ménages a augmenté de 36 % entre 2019 et 2022. Cette hausse reflète le placement, sous forme d’épargne liquide, des transferts reçus pendant la crise mais aussi sans doute des gains réalisés par les ménages par la cession d’autres actifs financiers. La résilience de la croissance dépendra de la capacité des ménages à amortir le choc et donc de leur comportement d’épargne. Les transferts ont certes été plutôt orientés vers les classes moyennes mais les liquidités existantes aujourd’hui pourraient être plus concentrées sur les classes les plus aisées. C’est pourquoi nous anticipons cette légère remontée du taux d’épargne sur l’année 2023. Toutefois, il resterait inférieur au niveau observé en 2019 de telle sorte que la consommation serait le principal moteur de la croissance.

[1] Voir « États-Unis, pilotage à hauts risques », dans la Revue de l’OFCE, n° 180.

[2] Les dépenses publiques – consommation et investissement – ont été également dynamiques (+1,3 % et +0,5 % respectivement) mais contribuent de fait assez peu à la croissance : +0,2 point chacun.

[3] Nous anticipions en effet une croissance trimestrielle de la consommation des ménages de 0,3 %.

[4] Le revenu disponible brut nominal a progressé de 3 % sur le premier trimestre 2023 contre une prévision à 1,5 %.

[5] Voir « Le marché du travail américain résistera-t-il au resserrement monétaire ? », OFCE Le Blog du 20 avril 2023.

[6] En 1974, la récession est effectivement précédée d’un resserrement monétaire mais elle est également consécutive au premier choc pétrolier et à la fin du régime de Bretton-Woods qui ont déstabilisé l’économie mondiale. En 2008-2009, l’ampleur de la récession s’explique par la crise financière globale. La politique monétaire a sans doute joué le rôle de déclencheur en provoquant l’ajustement du marché immobilier dans un contexte de fortes vulnérabilités. Pour autant, la contribution de la politique monétaire, indépendamment de l’effet d’amplification financière, est incertaine.

[7] La contribution des salaires à la progression du revenu disponible brut nominal s’élève à 15,4 points et celle des transferts à 5,2 points.

[8] En pratique, cela n’implique pas que le taux d’épargne continuera de baisser en 2023 mais qu’il se maintiendra à un niveau inférieur à celui de 2019. La référence au taux d’épargne pourrait néanmoins biaiser notre estimation de la sur-épargne Covid. Sur une période plus longue (2000-2019), le taux d’épargne moyen s’élève à 6 %. Notre hypothèse pour 2023 reste néanmoins celle d’un taux d’épargne inférieur.

[9] Le déflateur de la consommation a effectivement augmenté de 14,1 % entre le quatrième trimestre 2019 et le premier trimestre 2023.