par Evens Salies

Les efforts technologiques fournis pour répondre aux exigences des politiques environnementales et la libéralisation des marchés de l’électricité sont-ils antinomiques ? En effet, l’évolution depuis trois décennies des dépenses de R&D des producteurs européens d’électricité peut nous faire douter de la capacité de l’Union européenne à atteindre son objectif de réduction des émissions de gaz à effet de serre de 80 à 93% d’ici à 2050 (Commission européenne, COM/2010/0639).

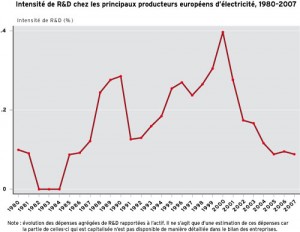

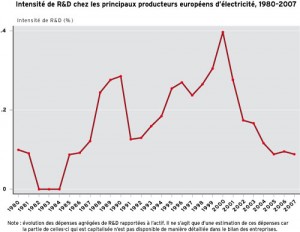

C’est ce que révèle le graphique ci-dessous, où nous avons isolé les dépenses des 15 principaux producteurs. Ce graphique met en évidence un étonnant retournement de tendance concomitant à la vague de libéralisation du secteur, souhaitée par l’Union européenne. Concomitance ne voulant pas dire causalité, nous nous sommes penchés sur l’éventuelle responsabilité de la libéralisation sur ce retournement.

Les dépenses de R&D des producteurs européens d’électricité ont fondu de 70 % entre 2000 et 2007, passant de 1,9 milliard d’euros à 570 millions d’euros environ (chiffres corrigés de l’inflation). Les géants EDF et E.ON, qui représentent les deux plus gros budgets R&D dans le secteur, sont largement responsables de cette baisse. Les dépenses de R&D de l’électricien français ont chuté de 33 % de 2000 à 2007, passant de 568 à 375 millions d’euros. Sachant que les charges de R&D sont majoritairement des charges de personnel, le lecteur ne s’étonnera pas d’apprendre que, dans le cas d’EDF, le nombre de salariés affectés à la R&D (chercheurs et personnel d’accompagnement technique et administratif) a été réduit d’environ un quart depuis 2007, sans que nous puissions précisément quantifier cette baisse par type d’activité.

Comment les producteurs peuvent-ils relever le défi technique des énergies alternatives avec une dépense de R&D si faible ? Certains pourraient penser que la situation n’est pas aussi dramatique que le laisse supposer le graphique ci-dessus. En effet, les dépenses de R&D des grands groupes de l’électricité ne représentent que la partie congrue du total, autour de 10 %, l’essentiel étant réalisé par des équipementiers et des laboratoires publics. En se penchant sur les chiffres de l’ensemble des dépenses privées, on constate une part relativement croissante depuis l’année 2000 de celles destinées non seulement à accroître l’efficience énergétique, mais aussi de celles destinées à la production d’électricité à partir de sources d’énergies renouvelables. Ceci est la conséquence de nombreuses aides en faveur de l’innovation (mesures de rachat de l’électricité « verte », financement de projets réunissant des partenaires publics/privés, etc.), sans oublier le crédit d’impôt-recherche dont bénéficie d’ailleurs EDF.

Il vaut mieux cependant attendre avant de se réjouir du déplacement susmentionné de l’activité d’innovation environnementale des producteurs vers les équipementiers dans la mesure où la concurrence risque d’avoir pour effet de peser sur la capacité de ces premiers à acheter ces innovations. La question du pourquoi de la chute des dépenses de R&D reste donc pertinente. Etaient-elles anormalement élevées dans le passé, lorsque les producteurs jouissaient du statut de monopole public ? On peut cependant trouver des raisons objectives à leur baisse, en commençant par la libéralisation des marchés dans l’Union européenne qui, comme l’ont montré plusieurs études, est l’événement déclencheur de ce changement radical dans la politique d’innovation des producteurs d’électricité [1].

La thèse défendue dans ces études est que l’accroissement prévisible de la concurrence, à la suite de l’ouverture des marchés, rend la valeur des revenus futurs des producteurs plus incertaine. L’argument avancé pour soutenir cette thèse est que certains projets de recherche orientés vers des objectifs d’intérêt public (ceux qui permettront de réduire les émissions) ne confèrent pas à court terme des réductions de coûts qui seraient profitables aux producteurs. Les producteurs se sont recentrés sur leur cœur de métier et ont abandonné les programmes de recherche pour lesquels ils n’ont pas d’avantages tangibles, notamment en termes de brevets. En Europe, les projets d’innovation environnementale sacrifiés continuent, en revanche, à être développés chez des équipementiers (Vestas pour l’éolien, par exemple). Quand aux recherches dans l’électronucléaire, elles sont accaparées par les prestataires de recherche comme Areva ou Siemens. Les producteurs tendent à leur substituer des programmes autour de la maîtrise de la demande d’énergie ou de l’amélioration d’efficience énergétique qui requièrent des temps de recherche moins longs. Il faut noter que la nature de bien public de l’innovation rend prudents les producteurs qui devraient supporter le coût de projets de recherche dont ils ne seront pas seuls à récolter les bénéfices. Cela favorise le comportement de « passager clandestin » de certains et conduit donc à un sous-investissement en R&D au niveau agrégé dans le secteur.

De manière intéressante, on constate que ce décrochage succède à une accélération des dépenses de R&D avant la période de libéralisation. Ce fait d’abord observé aux Etats-Unis, s’observe clairement en Europe si l’on se penche sur les dépenses de R&D en niveau. Dès 1996, date à laquelle fut votée la directive contenant les règles communes pour le marché intérieur de l’électricité, la baisse des dépenses suit une hausse plus forte que celle observée, en moyenne entre 1980 et 1995.

Cependant, l’instauration de règles de marché n’explique pas tout. S’est opérée une restructuration/fragmentation du secteur avec ouverture du capital qui n’est pas sans conséquences sur l’innovation. De manière similaire à ce qu’on a pu observer dans d’autres secteurs comme les TIC, le comportement des grands groupes de l’électricité a été de s’endetter – nécessairement au détriment des dépenses de recherche et d’autres investissements – en réalisant des opérations de croissance externe. Les firmes réorganisent leur activité de recherche en les externalisant. L’exemple en France est celui d’EDF Energies Nouvelles, 100 % filiale d’EDF depuis le mois d’août 2011. L’organisation industrielle qui prévaut aujourd’hui dans le secteur de l’énergie électrique est un oligopole avec frange concurrentielle (voir encadré). Bien que soumis à une séparation comptable de leurs activités, les principaux producteurs historiques restent verticalement intégrés de la production à la commercialisation.

Cette fragmentation/restructuration renvoie à une hypothèse de recherche bien connue des économistes sur l’avantage des grandes entreprises en termes d’innovation : l’hypothèse schumpétérienne [2]. Formellement, il s’agit de savoir si l’intensité de R&D, c’est-à-dire le ratio entre les dépenses de R&D et une variable de taille (l’actif du bilan, par exemple), est corrélée positivement à la taille. Nous avons pu montrer ce lien pour un échantillon des 15 principaux producteurs européens d’électricité pour la période 1980-2007 [3] . Or, ce résultat est largement contingent à la période étudiée, durant laquelle la plupart des producteurs étaient protégés de l’entrée et de toute pression concurrentielle sur le territoire où ils exerçaient leur activité en tant qu’entreprises publiques désignées alors « monopoles naturels ».

Cette position leur conférait au moins trois avantages qui ont maintenant disparu. Tout d’abord, une sorte de droit de préemption sur l’utilisation des innovations fournies par les constructeurs d’équipements, ou de leurs propres innovations, craignant moins ainsi d’être imités. Pour chaque entreprise, les possibilités de réplication étaient limitées à une zone d’activité bien précise, généralement le territoire national, permettant de répartir les coûts liés à l’innovation sur tous les consommateurs domestiques. De plus, étant certains de ne pas perdre de clients, les opérateurs historiques pouvaient prendre le risque de lancer des projets de recherche fondamentale. Enfin, la réglementation des tarifs assurait un niveau de recette prévisible.

On peut donc penser que l’effet schumpétérien d’appropriation de la rente a dominé l’effet négatif sur l’incitation à innover dû au manque de concurrence réelle ou potentielle. Une fois le secteur ouvert à la concurrence, certains des avantages susmentionnés ont disparu. La grande majorité des clients reste fidèle à cause de coûts de migration importants, mais une partie croissante de l’électricité produite est vendue sur des marchés de gros peu régulés, aux prix volatils. L’hypothèse schumpétérienne pourrait donc disparaître. La concurrence serait donc en train de nuire à l’innovation induite par les dépenses de R&D.

Oligopole de producteurs avec frange concurrentielle

Dans le secteur européen de l’énergie électrique, il s’agit d’un petit nombre de gros producteurs (l’oligopole) qui détiennent une vaste part de marché, pendant qu’un grand nombre de petites entreprises (la frange concurrentielle) détiennent, chacune, une petite part du marché résiduel. Contrairement à l’idée que l’on se fait de la concurrence, la frange peut avoir une influence sur les prix de gros. En effet, l’électricité ne se stockant pas, un producteur sollicité par le transporteur responsable de l’équilibre production-consommation, peut offrir les MWh d’une centrale dont le coût marginal de génération est faible à un prix supérieur à ce coût. C’est le cas du producteur de la centrale marginale qui, en période où la demande butte sur les capacités de production (la pointe), est sollicité pour assurer l’équilibre global en dernier recours.

[1] L’étude de Kammen, D.M. et R. M. Margolis (Underinvestment: the energy technology and R&D policy challenge, Science, Energy–Viewpoint, n° 285, 1999, pp. 690-692) avait anticipé cette situation pour les Etats-Unis. L’étude de P. Sanyal (The effect of deregulation on environmental research by electric utilities. Journal of Regulatory Economics, Vol. 31, n° 3, 2007, pp. 335-353) est la première à montrer de manière économétrique le rôle de la libéralisation des marchés de l’électricité sur la baisse des dépenses de R&D.

[2] Le lecteur pourra se référer à http://fr.wikipedia.org/wiki/Destruction_cr%C3%A9atrice.

[3] A test of the Schumpeterian hypothesis in a panel of European electric utilities, Document de Travail de l’OFCE, n° 2009-19, http://www.ofce.sciences-po.fr/pdf/dtravail/WP2009-19.pdf.