Pas de “TVA sociale” mais une “CSG sociale” ?

La dégradation de l’emploi et du solde des échanges extérieurs de la France incite à une réflexion sur la compétitivité des entreprises françaises. Mais comment rétablir cette compétitivité ? Est-ce un problème de coût du travail, comme l’affirme avec insistance le MEDEF ? Ou ce facteur n’entre-t-il finalement que pour une faible part dans l’explication de ces médiocres performances ?En choisissant, au printemps dernier, l’option de la « TVA sociale » – augmentation de 1,6 point du taux normal de TVA et affectation du surcroît de recettes à une baisse des cotisations sociales patronales, de l’ordre de 13 milliards d’euros, ciblée sur les salaires compris entre 1,3 et 1,6 SMIC –, le précédent gouvernement avait clairement privilégié la stratégie de baisse – modérée – du coût de la main-d’œuvre. En décidant de revenir sur cette hausse de TVA, qu’il considère injuste, le gouvernement actuel semble indiquer que l’allègement du coût du travail n’est pas sa priorité. Dans le même temps, pourtant, le discours du Président de la République en ouverture de la Conférence sociale ouvre la voie à une réflexion sur le financement de la protection sociale, suggérant ainsi que la question de l’allègement du coût du travail n’est pas close, mais que l’instrument préféré pourrait être la Contribution sociale généralisée (CSG). Sans craindre le pléonasme, certains évoquent désormais une « CSG sociale » !

1 – Coût du travail : la France a-t-elle un problème ?

Le coût de la main-d’œuvre est-il plus élevé en France que chez nos partenaires, notamment au sein de la zone euro ? Le diagnostic n’est, en réalité, pas aisé, et les avis divergent. Selon les données publiées par Eurostat, et qui concernent l’ensemble du secteur marchand, le coût horaire de la main-d’œuvre atteignait, en 2011, 34,20 euros en France, soit près de 7 euros de plus que la moyenne des pays de la zone euro. En Allemagne, il n’était que de 30,1 euros, mais dépassait 39 euros en Belgique. Pourtant, cet indicateur ne renseigne guère sur la compétitivité-coût, puisqu’il faut prendre en compte les différences de productivité de la main-d’œuvre. C’est donc habituellement sur la base du coût unitaire de main-d’œuvre – ou coût salarial unitaire, c’est-à-dire le coût de main-d’œuvre par unité produite – que l’on compare les compétitivités ; mais on ne dispose pas de mesure fiable des niveaux relatifs, de sorte qu’il faut se contenter d’indice et de variations.

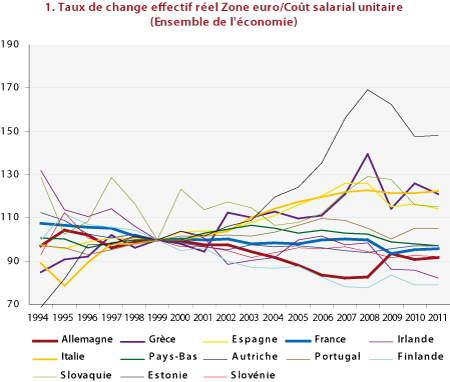

En se référant toujours aux données fournies par Eurostat, on peut se faire une idée de l’évolution relative des positions compétitives des différents pays européens. Pour tenir compte d’éventuels effets des variations de change entre les monnaies, l’indicateur de compétitivité-coût retenu ici est le taux de change effectif réel, calculé sur la base des coût salariaux unitaires, qui pondère les coûts relatifs des partenaires commerciaux en fonction de leur part dans les échanges extérieurs du pays considéré : une hausse de cet indice mesure donc une perte de compétitivité des entreprises du pays. Plusieurs mesures sont disponibles, couvrant des champs géographiques ou sectoriels différents.

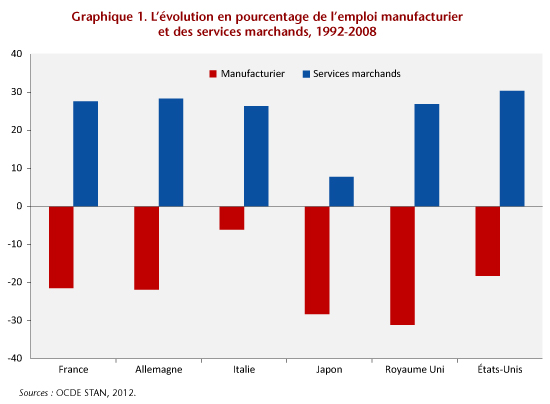

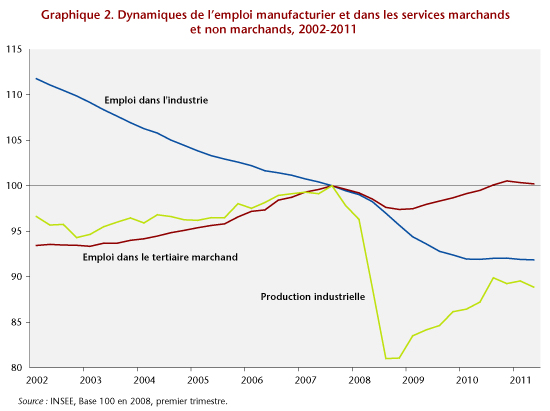

Si l’on se penche d’abord sur les compétitivités relatives au sein de la zone euro, où, par définition, il n’y a pas d’effet de change (Graphiques 1 et 2), le message est ambigu : pour l’ensemble de l’économie, les évolutions de la compétitivité française sont très voisines de celles de l’Allemagne, depuis le lancement de la monnaie unique, l’une et l’autre tendant à améliorer leur compétitivité-coût par rapport à leurs partenaires de la zone. Certes l’Allemagne faisait un peu mieux jusqu’en 2008 ; mais la récession de 2009 y a si fortement ralenti la productivité de la main-d’œuvre – du fait notamment d’un recours massif au chômage partiel – que les gains relatifs par rapport à la France s’en sont trouvés pratiquement effacés.

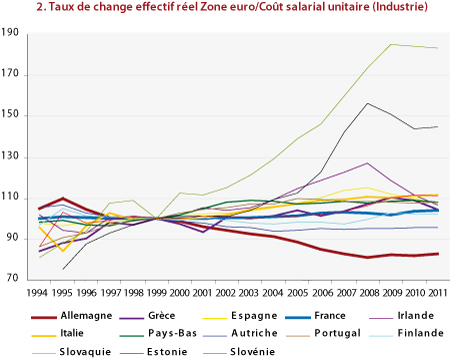

Pourtant, l’indicateur se référant à la seule industrie manufacturière délivre un message bien différent (graphique 2) : en moyenne depuis le lancement de l’euro, la compétitivité-coût de l’industrie française par rapport à ses partenaires de la zone s’est sensiblement maintenue, se dégradant très légèrement sur la période ; mais dans le même temps, l’industrie allemande a, quant à elle, très substantiellement amélioré la sienne – de près de 20%.

Source : Eurostat.

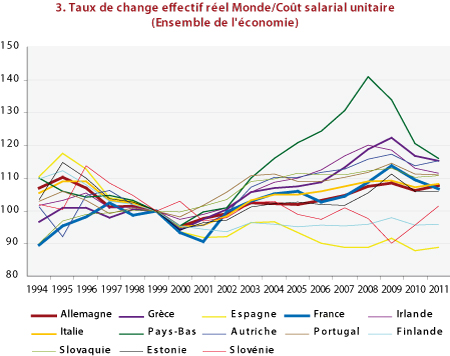

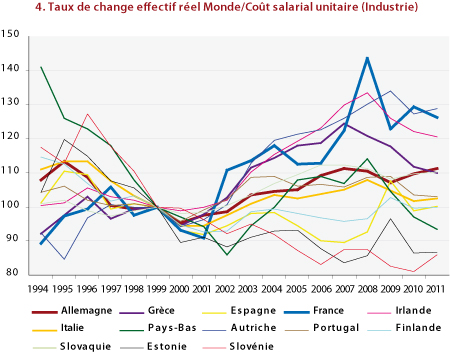

Si l’on se penche, maintenant, sur la compétitivité-coût française vis-à-vis des pays tiers, hors zone euro, les évolutions sont, de manière peu surprenante, dominées par les variations du taux de change externe de l’euro : l’appréciation réelle de la monnaie européenne depuis 2000 a dégradé la compétitivité-coût des économies française et allemande dans des proportions comparables (graphique 3). Mais dans l’industrie (graphique 4), la modération salariale allemande a permis de limiter la dégradation à un peu plus de 10 % entre 2000 et 2011, tandis que, sur la même période, la dégradation subie par l’industrie française est voisine de 25 % ; elle a même dépassé 40 % pendant la période où le taux de change de l’euro battait des records (été 2008).

Il est difficile, dans ces conditions, de nier la dégradation de la position compétitive de l’économie française et, singulièrement, de son industrie. Certes, la dépréciation récente de l’euro lui permet de réduire un peu les pertes de compétitivité subies au cours des années antérieures ; mais elle ne modifie pas les positions relatives au sein de la zone euro, qui concentre environ 2/3 du commerce extérieur de ses membres.

Source : Eurostat.

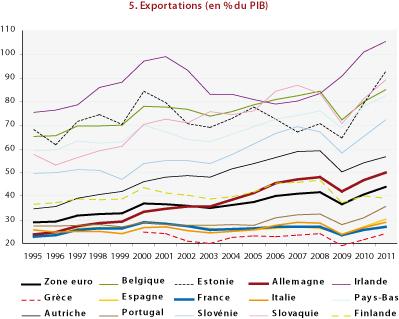

Au contraire, la stratégie compétitive de l’Allemagne – notamment grâce à une politique soutenue de modération salariale, mais aussi à des choix de restructuration industrielle et de spécialisation – se reflète dans la progression spectaculaire de son taux d’ouverture commerciale (graphique 5) : proche de celui de la France en 1995, il a doublé en Allemagne, alors qu’il est demeuré sensiblement constant en France.

Source : Eurostat.

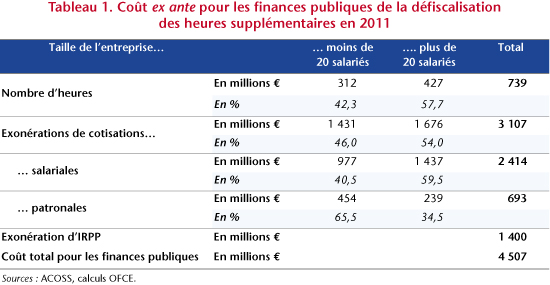

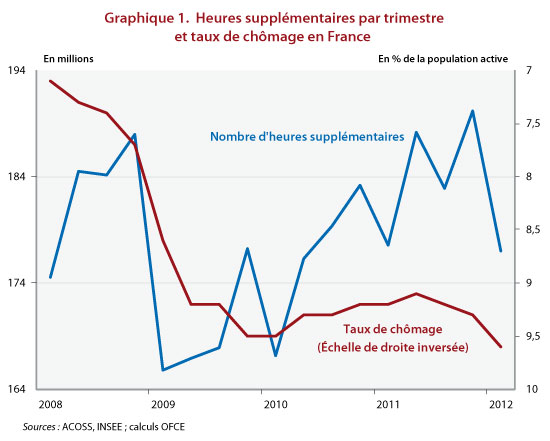

2 – Une réforme fiscale pour alléger le coût du travail

Le coût de la main-d’œuvre n’est sans doute pas le seul facteur de dégradation de la compétitivité de l’économie française et, notamment, de son industrie ; mais ses évolutions comparées à celles observées chez nos principaux partenaires, et singulièrement en Allemagne, suggèrent qu’elles contribuent aux mauvaises performances enregistrées ces dernières années tant en matière d’emploi que de commerce extérieur. Il apparaît donc légitime de s’interroger sur les moyens de l’alléger, en particulier en réformant le financement de la protection sociale, qui en constitue une composante importante. D’où le débat sur la baisse des cotisations patronales, et sa compensation par la hausse d’un autre prélèvement : TVA ou CSG ?

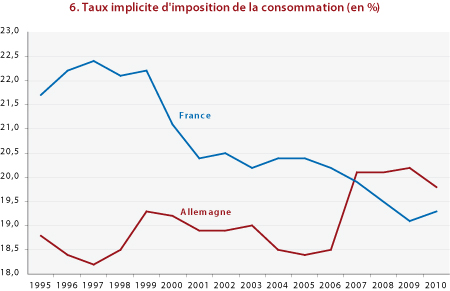

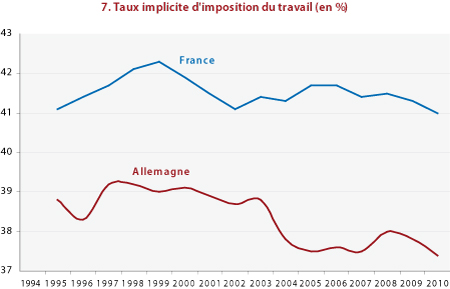

Beaucoup de choses ont été dites sur les avantages et les inconvénients de chacune des deux options[1]. Mais quelques éléments de comparaison des évolutions récentes permettront sans doute d’éclairer ce débat. En premier lieu, le poids respectif de la fiscalité pesant sur la consommation et sur les revenus du travail a connu, au cours des dernières années, des évolutions sensibles en France et en Allemagne (graphiques 6 et 7) : tandis que le taux implicite d’imposition de la consommation n’a cessé de se réduire en France depuis la fin des années 1990, sous l’effet de la baisse d’un point du taux normal de TVA et de mesures sectorielles (restauration et travaux dans les logements anciens), il a augmenté en Allemagne du fait de la hausse de 3 points du taux normal de TVA en 2007 ; dans le même temps, le taux implicite d’imposition du travail est demeuré assez stable, à un niveau élevé, en France, tandis qu’il se réduisait en Allemagne.

Source : Eurostat.

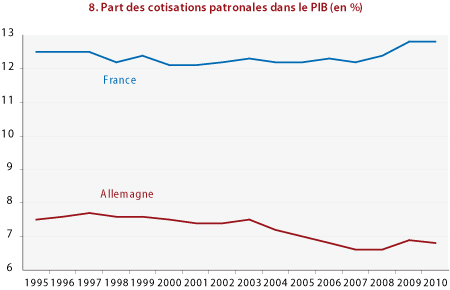

Et cette réduction a été obtenue en partie grâce à une baisse significative – environ 1 point de PIB – des cotisations sociales employeurs, qui sont, au contraire, restées à un niveau élevé en France (graphique 8).

Dans ces conditions, des marges de manœuvre semblent exister du côté de la fiscalité pesant sur la consommation, ce qui avait incité le précédent gouvernement à opter pour un alourdissement de la TVA, compensé par une réduction de cotisations sociales employeurs, que l’actuelle majorité vient d’abroger.

Parmi les défauts d’une hausse de la TVA, deux caractéristiques ont été mises en exergue dans les débats récents. En premier lieu, une telle hausse est, de fait, une « dévaluation fiscale », qui peut dès lors être considérée comme non coopérative et inamicale par nos partenaires au sein de la zone euro, d’où proviennent plus de la moitié de nos importations. Bien sûr, mais de leur côté, presque tous nos partenaires n’ont pas hésité à augmenter la TVA ces dernières années, et certains prévoient même de l’alourdir encore ; la France a donc, effectivement subi les « dévaluations fiscales » de ses voisins. Bien sûr, une stratégie européenne coordonnée serait préférable ; mais la France doit-elle décider de subir seule les coûts économiques de l’absence d’une telle coopération ?

Source : Eurostat.

En second lieu, les détracteurs de la hausse de la TVA pointent son caractère « injuste » et les risques d’amputation du pouvoir d’achat, donc de freinage de la croissance. Mais, comme le soulignait la précédente note sur ce thème, la hausse des prix résultant d’une augmentation du taux de TVA devrait être très limitée et, dans l’éventualité d’une hausse, les procédures d’indexation des minima sociaux, du SMIC et des retraites sont telles que les catégories disposant des revenus les plus modestes ne devraient pas subir de baisse de pouvoir d’achat. Sauf, bien sûr, si le gouvernement envisageait de suspendre les mécanismes d’indexation, ce qui constituerait une manière particulièrement opaque de rogner la générosité de la protection sociale et le salaire minimum.

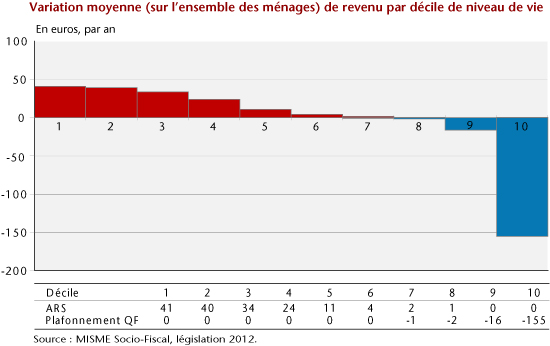

La CSG est-elle plus « juste » ? On fait volontiers valoir qu’avec son assiette large – la quasi-totalité des revenus –, elle frappe les revenus du patrimoine. Mais elle frappe aussi tous les bas revenus, qu’ils soient du travail, de remplacement, ou de retraite, dès le premier euro, car elle est proportionnelle : pour les détenteurs de revenus modestes, elle pèsera donc plus lourdement sur le pouvoir d’achat que la hausse de la TVA.

On peut souhaiter, malgré tout, privilégier la CSG, instrument de prélèvement à assiette large qui permet de faire contribuer l’ensemble des revenus au financement de la protection sociale : c’était, dès le départ, sa justification et sa raison d’être. Mais dans ce cas, le souci de justice exigerait que l’on accompagne cette montée en puissance d’une réforme fiscale plus ambitieuse, qui redonne une véritable progressivité à l’ensemble de prélèvements directs et, si possible, aux transferts sociaux sous condition de ressources.

Alléger le coût du travail en transférant la charge d’une partie du financement de la protection sociale vers des prélèvements autres que les cotisations sociales apparaît souhaitable et possible, tout en rendant le système fiscal français plus juste. Pour ce faire, il convient de compenser la baisse des cotisations sociales, patronales, mais aussi éventuellement salariés, par un alourdissement des prélèvements pesant sur la consommation et sur les activités polluantes, afin de modifier résolument les prix relatifs, donc les incitations qui pèsent sur les entreprises et les ménages dans leurs choix de techniques de production et d’emploi et dans leurs choix de consommation ; et de conduire en même temps une réforme de la fiscalité directe qui permette de compenser les effets négatifs de ces modifications sur le pouvoir d’achat des détenteurs de revenus modestes et de rendre l’ensemble des prélèvements directs plus progressifs. Alourdir la CSG sans conduire cette grande réforme[2] serait léser ces catégories.

[1] Voir notamment, J. Le Cacheux, 2012a, « La TVA « sociale », antisociale ? », Blog de l’OFCE, 6 janvier, et E. Heyer, M. Plane et X. Timbeau, 2012, « Impact économique de la « quasi TVA sociale ». Simulations macroéconomiques et effets sectoriels », Débats et politiques, Revue de l’OFCE, n°122, sous la direction de G. Allègre et M. Plane, « Réforme fiscale », mars.

[2] Pour une exposition plus précise des principes d’une telle réforme, voir J. Le Cacheux, 2012b, « Soutenabilité et justice économique. Finalités et moyens d’une réforme fiscale », Débats et politiques, Revue de l’OFCE, n°122, sous la direction de G. Allègre et M. Plane, « Réforme fiscale ».